运行PUE:1.06

制冷系统运行能耗<50KW

主要制冷方式:超算节点液体冷却+风冷辅助。

建设方:斯洛文尼亚信息科学研究所IZUM

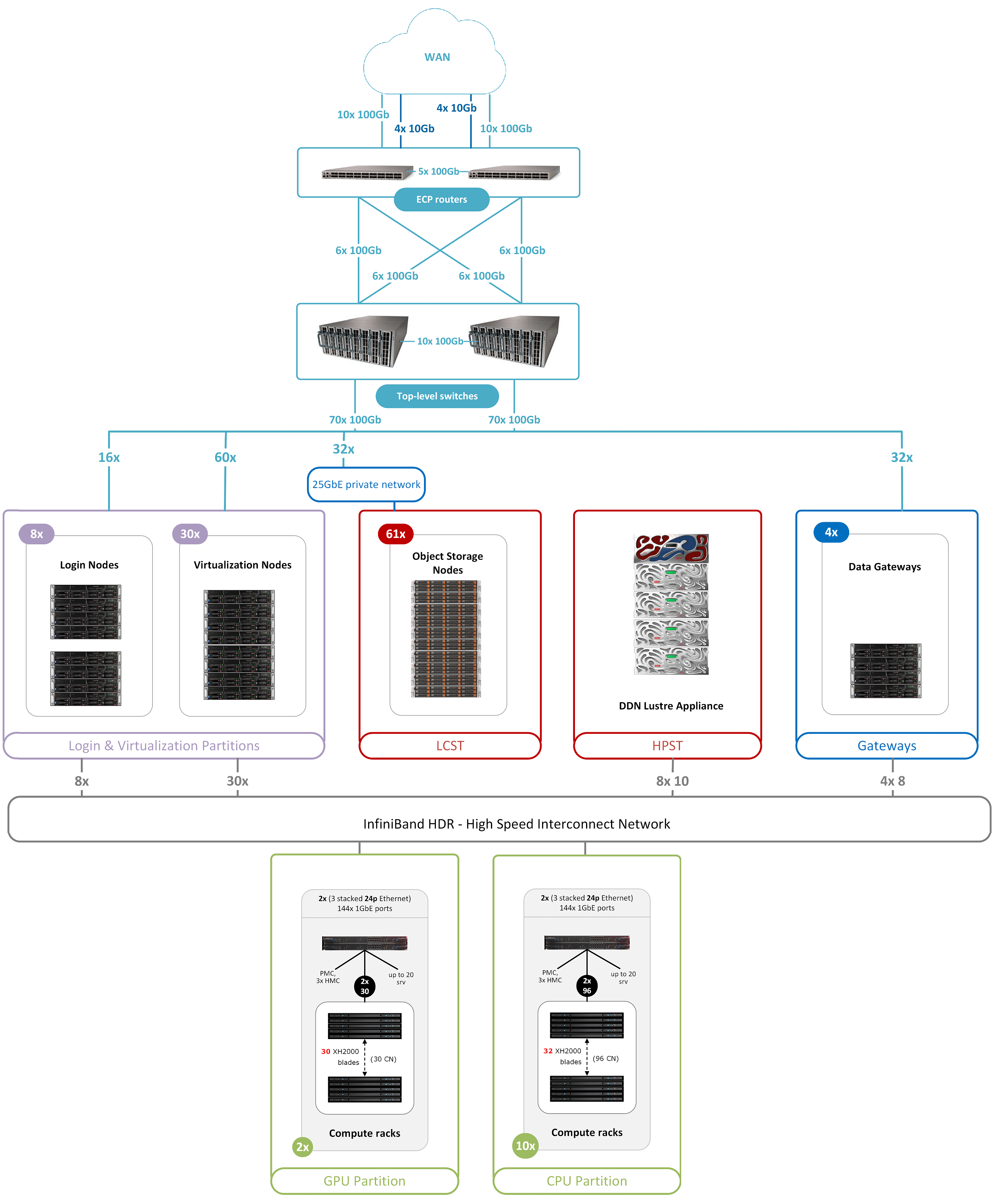

计算网络:HDR 8700 200G infiniband,存储网络HDR100 100G infiniband,inband ethernet 50G,outband ethernet 10G,ipmi 1G。

运算能力:引用官方数据

持续性能:6,8 petaflops;

峰值性能:10,1 petaflops;

计算分区:CPU 分区:960 个节点,256GB 内存/节点,20% 双倍内存,HDR100 和 GPU 分区:60 个节点,HDR200,;

中央处理器 (CPU):122.800 个内核,1920 个 CPU,AMD Epyc 7H12;

图形处理单元 (GPU):240 张英伟达 A100 卡;

存储容量:高性能NVMe Lustre(1PB),大容量Ceph(23PB);

应用:传统计算、人工智能、大数据/HPDA、大规模数据处理;

其他细节:向其他国家和国际计算中心传输数据的宽带宽(高达500 Gbit/s)。高性能存储的数据处理吞吐量为 400GB/s,大容量存储的数据处理吞吐量为 200Gb/s。

超算节点技术提供商:ATOS提供的解决方案“BullSequana XH2000”。

整机柜数量:12*BullSequana XH2000。

整个占地面积:100m2

分区:2个分区,一个超算的液冷、风冷混合散热,一个网络和存储风冷散热。风冷散热冷冻水机组和冷却塔两个分区共用。

该算力目前处在最新的TOP 500的第166名。

刀片节点上的存储液冷area

XH2000整柜交付的液冷分布式CDU和计算单元

XH2000整柜交付的液冷分布式CDU和计算单元

机柜前视图(中间白色是电力DCIM监控)

从纰漏的信息和图片集来看,欧洲的HPC项目物理设施层的可靠性应该在Tier Ⅲ级别。

电力上连续供电是两组10kv的中压1.2MW和一组中压发电机作为一级电源输入,经过两套独立供电系统为末端提供双母线供电能力,基本上电力的问题

冷板分布式液冷的可靠性在这个项目上比较高,主要有两点,从xh2000机柜系统的技术资料上看,该整机柜的分布式CDU是2N配置,也就是说每个机柜输入的进出水都是双循环的,可以避免单管路的故障导致超算设施过热降频或宕机,而且从现场拍摄的水路布管方式,采用的是主管路通过定制硬连接分水管的方式进入机柜内的液冷CDU输入点。这样的方式对装配和安装的工艺要求是比较高的。

通过对静电地板底部的高度判断,大概在60公分左右,在60公分的下部空间里,还要做为风冷送风的静压箱,从这点上看可以大致上判断该项目的整机柜风液散热比例至少在20:80左右,对风冷的需求较小,其静压箱出风口风量也应该是做过CFD仿真评估的,柜内主要散热要求可能来自于顶部的电源PSU组件。超算节点的液冷比例是比较高的,达到90%以上。

通过两年的运行结论,该超算的综合整体能耗在1.3,细分下来的能耗水平是超算区1.06,存储网络区1.66。还算不错的能耗区间。

通过咨询考证,了解到当时这个项目的CDU供水温度是35℃,出水温度是50℃,冷却塔效率最高的工况是室外湿球温度33℃的设计。二次机柜内循环水去离子纯水有进行添加剂处理,具体的添加剂未披露。

网络的完整拓扑如下:引自官方